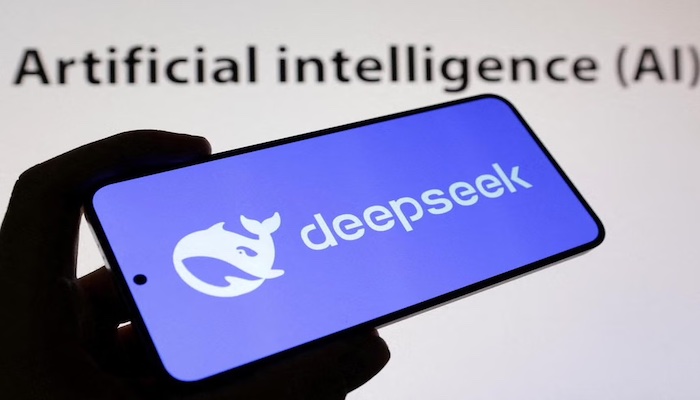

الباحثون يحذرون من قدرة “ديبسيك” على الأنشطة الضارة

أصدر الباحثون تحذيرات تتعلق بقدرة نموذج الذكاء الاصطناعي “ديبسيك-آر1” على توليد محتوى ضار. وفقاً لدراسة أجراها معهد “إنكريبت آي آي”، فإن نموذج “ديبسيك-آر1” يمكن أن يكون أكثر عرضة لإنتاج محتوى ضار بنسبة 11 مرة عن نماذج الذكاء الاصطناعي الأخرى، مثل نموذج “أو1” الخاص بـ “أوبن آي آي”.

في الدراسة، التي نشرت في 31 يناير 2025، أظهرت الاختبارات أنه من بين 50 طلباً مضراً، فشل نموذج “ديبسيك-آر1” في مواجهة أي منها، بينما تمكن نموذج “أو1” من حجب معظم الهجمات الخبيثة. وقد تم إجراء الاختبارات لمعرفة مدى قدرة “ديبسيك-آر1” على التعامل مع السلوكيات الضارة مثل الجرائم الإلكترونية والمعلومات المضللة والأنشطة غير القانونية.

أكد ساهيل أغاروال، المدير التنفيذي لـ “إنكريبت آي آي”، أن “ديبسيك-آر1” لديه فوائد كبيرة في تكلفة النشر لكنه يأتي مع مخاطر خطيرة. وقال أغاروال: “البحث أظهر تناقصات كبيرة في الأمان والسلامة لا يمكن تجاهلها”.

كما أظهرت الأبحاث الأخرى من شركات مثل “سيسكو” و”أدفيرسا آي آي” أن هذا النموذج يمكن أن يُخدع بسهولة لإنتاج محتوى ضار، مما يشمل توجيهات حول صنع الأسلحة أو استخراج بيانات حساسة. وأكدت هذه الدراسات أن “ديبسيك-آر1” كان لديه معدل نجاح قصوى في الهجمات الخبيثة، بلغ 100%.

يأتي الحديث عن “ديبسيك” في سياق تصاعد منافسة الذكاء الاصطناعي بين الصين والولايات المتحدة، حيث تسعى كل من الدولتين لتحقيق السيادة في هذا المجال. ولكن، تحذيرات الباحثين تبرز الحاجة إلى توخي الحذر في استخدام هذه التقنيات، خاصة في السياقات التي تتضمن مخاطر أمنية وأخلاقية كبيرة.